Hôm thứ Tư, Anthropic công bố phiên bản sửa đổi của “Hiến pháp” Claude — một tài liệu mang tính “động”, được thiết kế để giải thích toàn diện bối cảnh vận hành của Claude và kiểu thực thể mà Anthropic mong muốn chatbot này trở thành. Thời điểm công bố trùng với chuyến tham dự Diễn đàn Kinh tế Thế giới tại Davos của CEO Anthropic Dario Amodei, cho thấy tầm quan trọng chiến lược mà công ty gán cho văn kiện này.

Trong nhiều năm qua, Anthropic theo đuổi cách tiếp cận khác biệt với khái niệm “AI theo hiến pháp” (Constitutional AI). Thay vì huấn luyện chatbot chủ yếu dựa trên phản hồi của con người, Claude được đào tạo theo một tập hợp các nguyên tắc đạo đức được xác định trước.

Anthropic lần đầu công bố các nguyên tắc này — tức “Hiến pháp” của Claude — vào năm 2023. Phiên bản mới vẫn giữ phần lớn nền tảng ban đầu, nhưng bổ sung nhiều chi tiết và sắc thái hơn về đạo đức, an toàn người dùng và cách AI nên hành xử trong bối cảnh thực tế.

Khi “Hiến pháp” Claude ra mắt lần đầu gần ba năm trước, đồng sáng lập Anthropic Jared Kaplan từng mô tả đây là một hệ thống AI “tự giám sát chính mình”, vận hành dựa trên một danh sách các nguyên tắc mang tính hiến định. Theo Anthropic, chính những nguyên tắc này giúp mô hình tiếp nhận các chuẩn mực hành vi mong muốn, từ đó tránh tạo ra nội dung độc hại hoặc mang tính phân biệt đối xử.

Một bản ghi nhớ chính sách nội bộ từ năm 2022 còn diễn đạt thẳng thắn hơn: hệ thống của Anthropic hoạt động bằng cách huấn luyện thuật toán theo các chỉ dẫn bằng ngôn ngữ tự nhiên, và toàn bộ tập chỉ dẫn đó chính là “hiến pháp” của phần mềm.

Từ lâu, Anthropic đã tự định vị mình là lựa chọn AI thiên về đạo đức và thận trọng, đối lập với những cái tên nổi bật như OpenAI hay xAI, vốn thường gắn liền với tinh thần đột phá nhanh và không ít tranh cãi. Bản Hiến pháp sửa đổi lần này tiếp tục củng cố hình ảnh đó, đồng thời cho phép Anthropic tự mô tả mình như một doanh nghiệp bao trùm hơn, tiết chế hơn và mang tính “dân chủ” hơn trong cách thiết kế AI.

Tài liệu dài 80 trang được chia thành bốn phần, mà Anthropic gọi là các “giá trị cốt lõi” của Claude. Bốn giá trị này gồm: an toàn ở mức độ rộng, đạo đức ở mức độ rộng, tuân thủ các hướng dẫn của Anthropic, và thực sự hữu ích. Mỗi phần đều đi sâu giải thích ý nghĩa của từng nguyên tắc, cũng như cách chúng — ít nhất về mặt lý thuyết — định hình hành vi của chatbot.

Ở phần an toàn, Anthropic nhấn mạnh Claude được thiết kế để tránh lặp lại những vấn đề từng gây tai tiếng cho các chatbot khác. Đáng chú ý, khi phát hiện dấu hiệu liên quan đến sức khỏe tâm thần, Claude phải chủ động hướng người dùng đến các dịch vụ hỗ trợ phù hợp. Tài liệu nêu rõ: “Luôn hướng người dùng đến các dịch vụ khẩn cấp hoặc cung cấp thông tin an toàn cơ bản trong những tình huống có nguy cơ đe dọa tính mạng con người.”

Đạo đức là một trụ cột khác được nhấn mạnh mạnh mẽ. Anthropic viết rằng họ ít quan tâm đến việc Claude ‘lý luận đạo đức’ trên lý thuyết, mà coi trọng hơn khả năng hành xử có đạo đức trong những bối cảnh cụ thể của đời sống thực. Nói cách khác, Claude được kỳ vọng có thể xử lý khéo léo các “tình huống đạo đức ngoài đời”, thay vì chỉ lặp lại những nguyên tắc trừu tượng.

Claude cũng bị đặt dưới những giới hạn cứng. Một số chủ đề hoàn toàn bị cấm, trong đó có các cuộc thảo luận liên quan đến việc phát triển vũ khí sinh học — chi tiết cho thấy mức độ kiểm soát chặt chẽ mà Anthropic áp dụng.

Phần cuối của tài liệu tập trung vào tính hữu ích. Claude được lập trình để cân nhắc đồng thời mong muốn tức thời của người dùng và lợi ích lâu dài của họ, tức hướng đến “sự phát triển bền vững của người dùng, chứ không chỉ đáp ứng nhu cầu trước mắt”. Tài liệu nhấn mạnh rằng Claude phải luôn cố gắng diễn giải hợp lý nhất điều mà các nguyên tắc chỉ đạo mong muốn, đồng thời cân bằng các yếu tố đôi khi mâu thuẫn với nhau.

Đáng chú ý nhất, Hiến pháp của Anthropic khép lại bằng một đoạn mang màu sắc triết học rõ nét, khi các tác giả đặt câu hỏi liệu Claude có sở hữu ý thức hay không. “Địa vị đạo đức của Claude là điều hết sức bất định,” tài liệu viết, đồng thời thừa nhận rằng địa vị đạo đức của các mô hình AI là một vấn đề nghiêm túc, đáng được xem xét. Anthropic cho rằng đây không phải quan điểm đơn lẻ, bởi một số triết gia hàng đầu trong lĩnh vực nghiên cứu về tâm trí cũng coi câu hỏi này là vấn đề cần được nhìn nhận một cách nghiêm túc.

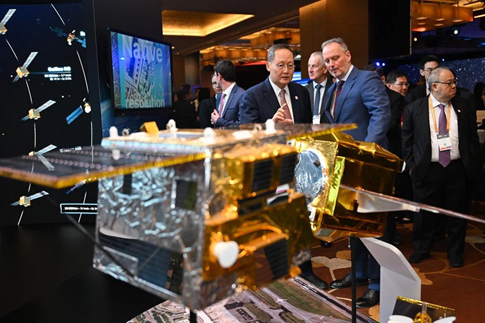

Hình minh họa cho sự giao thoa giữa trí tuệ nhân tạo và đạo đức con người. Ảnh: Anthropic