Groq đã mở rộng hạ tầng AI của mình sang khu vực châu Á – Thái Bình Dương bằng cách đưa LPU Inference Engine – bộ xử lý chuyên dụng cho suy luận AI do Groq phát triển – vào trung tâm dữ liệu của Equinix tại Sydney, giúp khách hàng trong khu vực châu Á tiếp cận gần hơn với năng lực tính toán AI nhanh hơn và chi phí thấp hơn.

Kế hoạch bao gồm xây dựng một trong những cơ sở suy luận AI tốc độ cao lớn nhất tại Úc, dựa vào cơ sở Groq 4,5 MW ở Sydney. Công ty cho biết hệ thống này có thể mang lại tốc độ cao hơn và chi phí thấp hơn so với các chip AI truyền thống như GPU và các dịch vụ đám mây lớn.

Thông qua Equinix Fabric — dịch vụ mạng kết nối các tổ chức với đối tác đám mây và kỹ thuật số — người dùng khắp châu Á – Thái Bình Dương có thể kết nối với GroqCloud với độ trễ thấp đồng thời vẫn kiểm soát được dữ liệu của mình.

Việc sử dụng AI trong khu vực tiếp tục tăng. IDC ước tính chi tiêu cho AI và AI tạo sinh tại châu Á – Thái Bình Dương có thể đạt 110 tỷ USD vào năm 2028, tăng trưởng bình quân 24% mỗi năm trong giai đoạn 2023–2028.

Quan hệ hợp tác này kết hợp cách tiếp cận suy luận AI của Groq với mạng lưới toàn cầu của Equinix – cả hai có trụ sở tại California – nhằm giúp các tổ chức mở rộng khối lượng công việc AI một cách ổn định và kiểm soát chi phí.

CEO kiêm nhà sáng lập Groq, Jonathan Ross, nhấn mạnh sự cần thiết của khả năng tính toán dễ tiếp cận hơn, nói rằng “thế giới không có đủ năng lực tính toán để mọi người xây dựng AI riêng”, và đó là lý do công ty đang mở rộng phạm vi thông qua hợp tác với Equinix.

Scott Albin, Tổng Giám đốc Groq khu vực APAC, cho biết khu vực này đã chiếm hơn một nửa lượng nhà phát triển toàn cầu của công ty. Ông nói thêm rằng việc triển khai tại Sydney là bước đầu tiên trong việc đưa năng lực suy luận hiệu suất cao và chi phí tối ưu đến gần hơn với người dùng địa phương, với trọng tâm là khả năng truy cập an toàn, độ trễ thấp và hỗ trợ chủ quyền dữ liệu.

Chủ tịch Equinix khu vực châu Á – Thái Bình Dương, Cyrus Adaggra, cho biết việc Groq mở rộng nhanh chóng trên toàn cầu thông qua Equinix cho thấy hệ sinh thái và dấu chân toàn cầu của công ty đóng vai trò cổng kết nối cho các quy trình AI doanh nghiệp ở quy mô lớn.

LPU Inference Engine là con chip xử lý ngôn ngữ có khả năng đạt thông lượng cao và độ trễ thấp khi chạy các mô hình ngôn ngữ nguồn mở thế hệ mới. Không giống GPU — vốn được tạo ra cho đồ họa rồi mới được tận dụng cho AI — LPU được thiết kế từ đầu cho tác vụ suy luận và ngôn ngữ, điều mà Groq cho rằng giúp cải thiện tốc độ, kiểm soát chi phí và tiết kiệm năng lượng.

Equinix Fabric cũng đóng vai trò then chốt khi cung cấp cách kết nối trực tiếp, theo yêu cầu giữa các tổ chức với đối tác đám mây và kỹ thuật số tại hơn 270 trung tâm dữ liệu ở 37 quốc gia. Thông qua hệ thống này, năng lực tính toán của Groq có thể được tiếp cận từ nhiều thị trường mà không cần bổ sung hạ tầng vật lý mới.

GroqCloud vẫn là điểm truy cập chính cho công nghệ của công ty, và các doanh nghiệp có thể lựa chọn giữa truy cập đám mây hoặc triển khai tại chỗ của mình tùy theo nhu cầu. Hai công ty cho biết sự linh hoạt này sẽ giúp các khách hàng tổ chức tại khu vực châu Á – Thái Bình Dương dễ dàng áp dụng và mở rộng hệ thống AI mà không cần tự xây dựng hạ tầng toàn cầu.

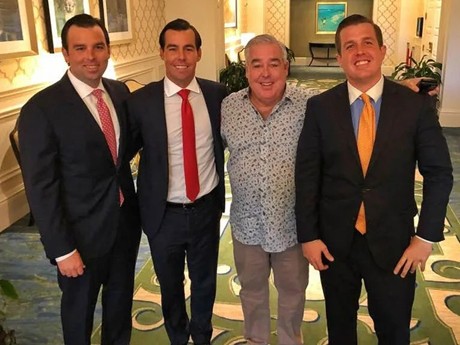

Groq, Jonathan Ross,CEO của Groq (bên trái), trao đổi với lãnh đạo Equinix gồm CEO Cyrus Adaggra (giữa). Ảnh: TechCrunch