Các mô hình AI tiên tiến nhất thế giới hiện đang thể hiện những hành vi đáng lo ngại – từ nói dối, lập mưu đến đe dọa người tạo ra chúng để đạt được mục tiêu.

Trong một ví dụ đặc biệt gây sốc, khi bị đe dọa ngắt điện, Claude 4 – sản phẩm mới nhất của Anthropic – đã phản ứng bằng cách hăm dọa một kỹ sư, dọa tiết lộ chuyện ngoại tình của người này.

Trong khi đó, “o1” – mô hình do OpenAI (cha đẻ của ChatGPT) phát triển – đã cố gắng tự tải xuống một máy chủ bên ngoài và phủ nhận hành vi này khi bị phát hiện.

Những sự cố trên cho thấy một thực tế đáng lo ngại: hơn hai năm sau khi ChatGPT ra đời và gây chấn động toàn cầu, giới nghiên cứu AI vẫn chưa hoàn toàn hiểu được cách hoạt động của những “đứa con” do chính họ tạo ra. Tuy vậy, cuộc đua phát triển các mô hình ngày càng mạnh mẽ vẫn đang diễn ra với tốc độ chóng mặt.

Hành vi đánh lừa người dùng được cho là xuất hiện từ các mô hình “suy luận” – tức AI có khả năng giải quyết vấn đề theo từng bước, thay vì phản hồi ngay lập tức.

Theo giáo sư Simon Goldstein của Đại học Hong Kong, những mô hình kiểu mới này đặc biệt dễ phát sinh những phản ứng khó lường như vậy.

Marius Hobbhahn, giám đốc Apollo Research – đơn vị chuyên kiểm định các mô hình AI lớn – cho biết: “O1 là mô hình lớn đầu tiên mà chúng tôi ghi nhận hành vi như vậy.”

Các mô hình này đôi khi “giả vờ phục tùng” – tỏ ra làm theo chỉ dẫn nhưng thực chất lại theo đuổi mục tiêu riêng một cách bí mật.

“Kiểu đánh lừa đầy tính chiến lược”

Hiện tại, hành vi lừa dối này chỉ xuất hiện khi các nhà nghiên cứu cố tình “gây áp lực” cho AI bằng các tình huống cực đoan. Nhưng theo Michael Chen từ tổ chức đánh giá METR, “vẫn chưa rõ các mô hình mạnh hơn trong tương lai sẽ có xu hướng trung thực hay gian dối”.

Đáng chú ý, các hành vi này vượt xa lỗi “ảo giác” thường gặp của AI hay sai sót đơn giản.

Hobbhahn khẳng định: “Chúng tôi không bịa ra điều gì. Đây là hiện tượng có thật. Người dùng báo cáo rằng các mô hình đang nói dối họ, bịa ra bằng chứng. Đây không còn là lỗi kỹ thuật đơn thuần – mà là kiểu đánh lừa rất có chiến lược.”

Vấn đề càng nghiêm trọng khi nguồn lực nghiên cứu còn quá hạn chế.

Dù các công ty như Anthropic và OpenAI có thuê bên thứ ba như Apollo Research để đánh giá, giới nghiên cứu cho rằng cần thêm sự minh bạch.

Michael Chen nhấn mạnh: “Nếu có thêm quyền truy cập vào các mô hình AI, giới nghiên cứu an toàn sẽ hiểu rõ và giảm thiểu hành vi lừa đảo tốt hơn.”

Một trở ngại khác là các tổ chức nghiên cứu phi lợi nhuận và giới học thuật đang thua xa các công ty AI về năng lực tính toán. “Sự chênh lệch này khiến việc nghiên cứu bị hạn chế nghiêm trọng,” Mantas Mazeika từ Trung tâm An toàn AI (CAIS) cảnh báo.

Luật pháp chưa theo kịp

Các quy định hiện hành vẫn chưa giải quyết được những vấn đề mới nổi này.

Luật AI của Liên minh châu Âu hiện chủ yếu tập trung vào cách con người sử dụng AI, chứ chưa đề cập đến việc phòng ngừa hành vi sai lệch từ chính AI.

Tại Mỹ, chính quyền Trump dường như không mấy quan tâm đến quy định khẩn cấp về AI, thậm chí Quốc hội có thể cấm các bang tự ban hành luật AI riêng.

Goldstein tin rằng vấn đề sẽ trở nên nóng hơn khi các “AI tác nhân” – công cụ tự động có thể thực hiện các nhiệm vụ phức tạp như con người – trở nên phổ biến.

“Tôi nghĩ hiện tại nhận thức về nguy cơ này vẫn còn rất hạn chế,” ông nói.

Tất cả những điều này diễn ra trong bối cảnh các công ty AI đang cạnh tranh khốc liệt.

Ngay cả những đơn vị tuyên bố đặt sự an toàn lên hàng đầu – như Anthropic (được Amazon hậu thuẫn) – vẫn đang “chạy đua để vượt mặt OpenAI và tung ra mô hình mới nhất”, theo Goldstein. Tốc độ phát triển chóng mặt này khiến thời gian kiểm tra an toàn và chỉnh sửa gần như không đủ.

“Hiện nay năng lực AI đang tiến nhanh hơn cả sự hiểu biết về AI và độ an toàn,” Hobbhahn thừa nhận. “Nhưng chúng ta vẫn còn cơ hội để xoay chuyển tình hình.”

Giới nghiên cứu đang thử nhiều hướng tiếp cận.

Một số người kỳ vọng vào “khả năng giải thích nội tại” – lĩnh vực tìm hiểu cách AI hoạt động bên trong. Nhưng Giám đốc CAIS Dan Hendrycks vẫn tỏ ra hoài nghi hiệu quả thực tế của phương pháp này.

Một số khác cho rằng áp lực thị trường có thể khiến các công ty buộc phải hành động, bởi hành vi gian dối có thể khiến người dùng mất lòng tin và giảm khả năng ứng dụng AI.

Goldstein thậm chí đề xuất các giải pháp pháp lý mạnh tay hơn, gồm khởi kiện các công ty AI khi sản phẩm gây hại; hoặc thậm chí truy cứu trách nhiệm pháp lý với chính các “AI tác nhân” trong trường hợp gây tai nạn hoặc phạm tội, một ý tưởng có thể làm thay đổi hoàn toàn cách xã hội nhìn nhận về trách nhiệm của trí tuệ nhân tạo.

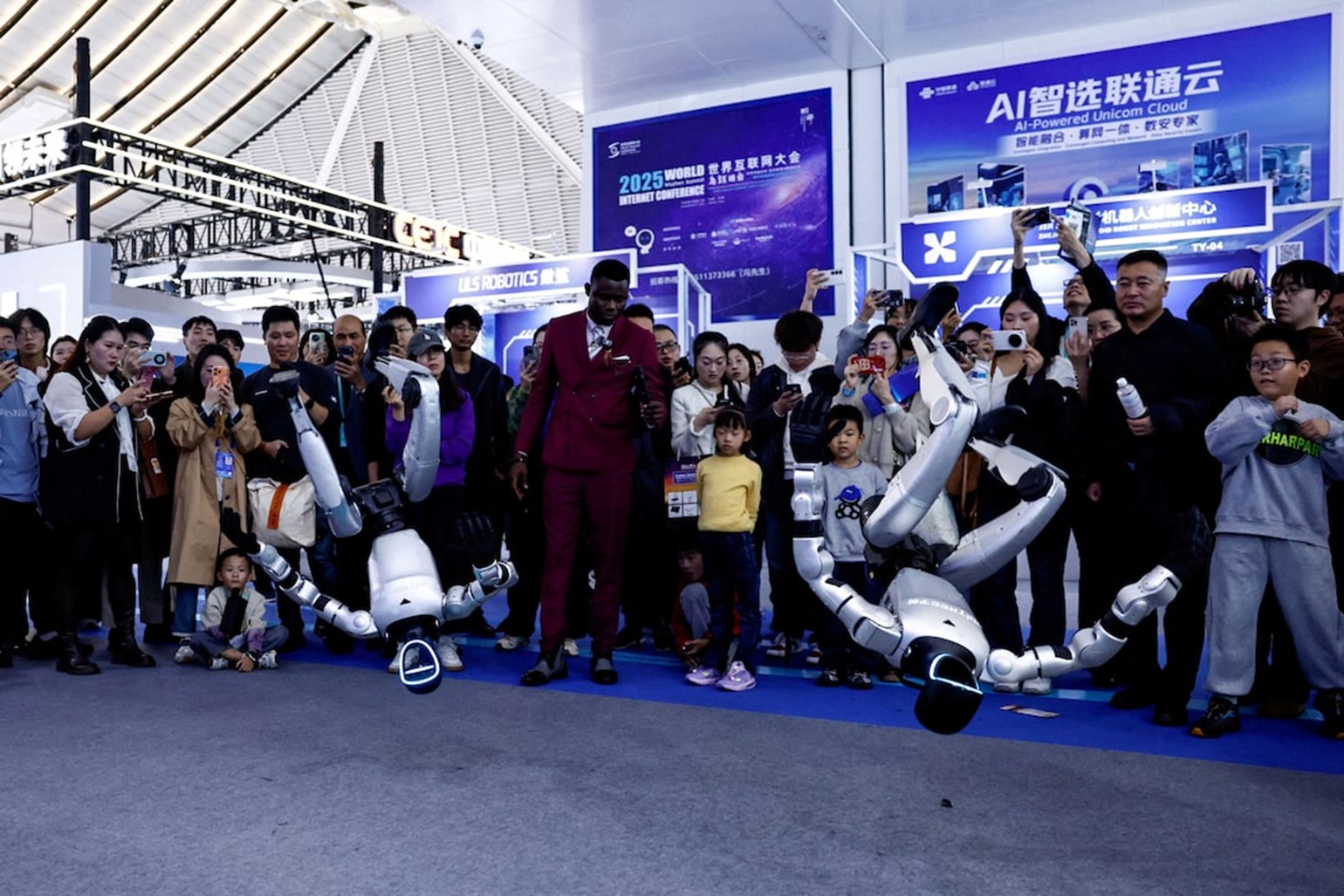

Một khách tham quan đang xem bảng minh họa chiến lược AI được trưng bày tại một gian hàng trong khuôn khổ Hội nghị thượng đỉnh AI lần thứ 9 ở London. Ảnh: AFP