Một hệ thống trí tuệ nhân tạo (AI) mang tính đột phá có tên Centaur có thể dự đoán các quyết định mà con người sẽ đưa ra trong nhiều tình huống khác nhau — thậm chí thường chính xác hơn cả các lý thuyết kinh điển trong tâm lý học vốn được dùng để mô tả lựa chọn của con người.

Các nhà nghiên cứu đã phát triển Centaur bằng cách tinh chỉnh một mô hình ngôn ngữ lớn (LLM) dựa trên một tập dữ liệu khổng lồ từ 160 thí nghiệm tâm lý học, trong đó 60.000 người đã thực hiện hơn 10 triệu lựa chọn trong nhiều loại nhiệm vụ.

Hầu hết các mô hình máy tính và lý thuyết nhận thức chỉ áp dụng cho một nhiệm vụ duy nhất. Ví dụ, AlphaGo của Google DeepMind chỉ có thể chơi cờ vây, còn lý thuyết triển vọng chỉ có thể dự đoán cách một người lựa chọn giữa mất mát và lợi ích.

Trái lại, Centaur có thể mô phỏng hành vi con người trong nhiều nhiệm vụ — bao gồm đánh bạc, trò chơi trí nhớ và giải quyết vấn đề. Trong các bài kiểm tra, Centaur thậm chí có thể dự đoán lựa chọn của con người trong những nhiệm vụ mà nó chưa từng được huấn luyện trước. Sự phát triển của Centaur được mô tả trong một bài báo công bố hôm nay trên tạp chí Nature.

Nhóm nghiên cứu tin rằng hệ thống này có thể trở thành công cụ hữu ích trong khoa học nhận thức. “Bạn có thể thực hiện các phiên thí nghiệm trên máy tính thay vì với người tham gia thật,” tác giả đồng nghiên cứu Marcel Binz, nhà khoa học nhận thức tại Viện Helmholtz về AI Lấy con người làm trung tâm tại Munich (Đức), cho biết.

“Việc xây dựng lý thuyết trong khoa học nhận thức rất khó,” nhà tâm lý ngôn ngữ Giosuè Baggio tại Đại học Khoa học và Công nghệ Na Uy nhận xét. “Thật thú vị khi thấy chúng ta có thể làm gì với sự hỗ trợ từ máy móc.”

Cạnh tranh khốc liệt

Từ lâu, các nhà khoa học đã vật lộn với việc sử dụng các mô hình chỉ phù hợp với từng nhiệm vụ cụ thể để mô phỏng hành vi con người một cách tổng thể, vì những công cụ này không thể tổng quát hóa cho nhiều loại tác vụ.

Binz và các cộng sự muốn vượt qua hạn chế đó. Họ dành 5 ngày để tinh chỉnh mô hình ngôn ngữ lớn Llama — được Meta phát hành — với một tập dữ liệu hành vi đồ sộ có tên Psych 101.

Họ điều chỉnh mô hình không chỉ để dự đoán hành vi trung bình của một nhiệm vụ, mà còn dự đoán phạm vi hành vi điển hình trong dân số. Sau đó, nhóm thử nghiệm khả năng dự đoán hành vi của những người không nằm trong dữ liệu huấn luyện.

Trong 31 trên 32 nhiệm vụ, Centaur vượt trội so với Llama và 14 mô hình nhận thức và thống kê khác. Nhiệm vụ duy nhất mà Centaur kém hơn là kiểm tra khả năng những người tham gia đánh giá câu văn có đúng ngữ pháp hay không.

Centaur cũng hoạt động tốt khi gặp những phiên bản biến thể của các nhiệm vụ nó đã được huấn luyện, và thậm chí cả những nhiệm vụ hoàn toàn mới như lý luận logic.

Điều này “cho thấy hành vi con người có cấu trúc rất rõ ràng,” theo Russell Poldrack, nhà thần kinh học nhận thức tại Đại học Stanford, California. “Nó thực sự nâng tầm tiêu chuẩn cho sức mạnh của các mô hình mà ngành tâm lý học nên hướng tới.”

Bản sao còn hạn chế

Dù có năng lực vượt trội, các nhà nghiên cứu cho biết Centaur vẫn còn giới hạn. Mô hình AI này chỉ dựa vào các nhiệm vụ dựa trên ngôn ngữ, Poldrack nói. Ví dụ, nó có thể dự đoán lựa chọn của người tham gia, nhưng không thể dự đoán mất bao lâu để người đó đưa ra quyết định.

Các tác giả cho biết họ đang mở rộng tập dữ liệu huấn luyện, lên gấp 4 lần kích thước hiện tại. Phần lớn dữ liệu hiện nay đến từ các nhóm dân cư phương Tây, có học thức và tư duy công nghiệp hóa — điều này có thể làm giảm khả năng áp dụng rộng rãi của Centaur với các nhóm dân cư đa dạng hơn.

Binz nói bước tiếp theo là Centaur — hiện đã mở cho cộng đồng nghiên cứu truy cập miễn phí — “cần được xác thực độc lập bởi cộng đồng khoa học.” Binz nói thêm: “Hiện tại có lẽ đây là phiên bản tệ nhất của Centaur mà chúng ta từng có, nghĩa là nó sẽ chỉ có thể tốt lên từ đây.”

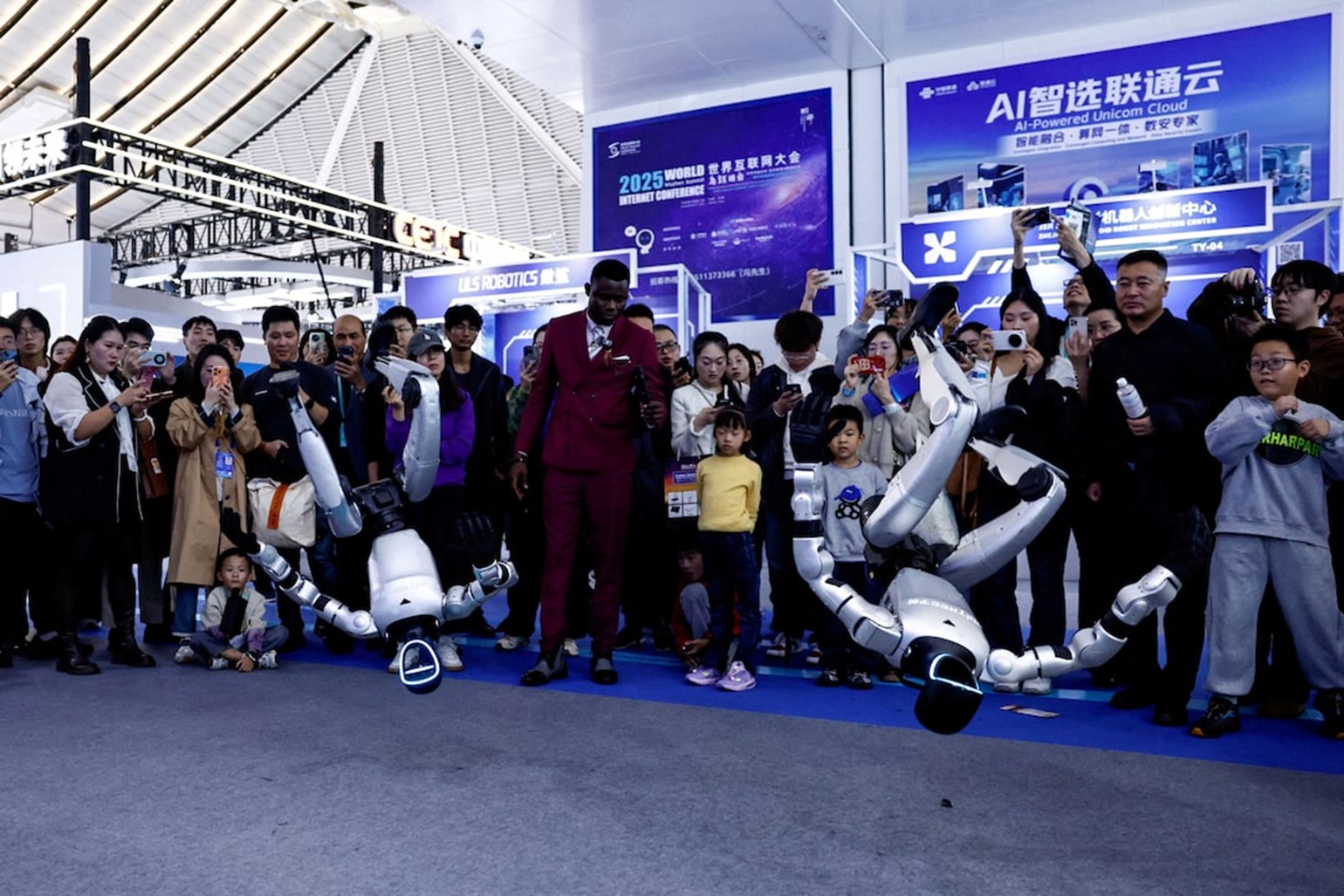

Các nhà nghiên cứu đã phát triển một công cụ AI mô phỏng khả năng ra quyết định của con người trong nhiều loại nhiệm vụ. Ảnh: Getty